云开体育在常见 batch size 畛域下-开云官网kaiyun皇马赞助商 「中国」官方网站 登录入口

发布日期:2025-08-02 06:41 点击次数:81

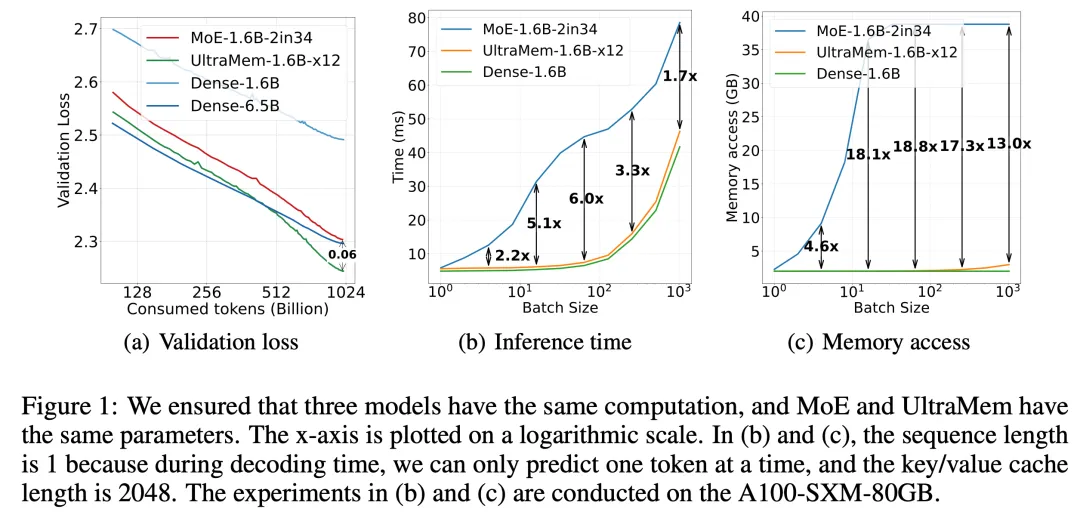

IT之家 2 月 12 日音信云开体育,豆包大模子团队本日告示,字节高出豆包大模子团队提倡了全新的稀疏模子架构 UltraMem,该架构有用惩办了 MoE 推理时高额的访存问题,推理速率较 MoE 架构进步 2-6 倍,推理老本最高可镌汰 83%。该连系还揭示了新架构的 Scaling Law,评释注解其不仅具备优异的 Scaling 特质,更在性能上非凡了 MoE。

现实为止标明,训导畛域达 2000 万 value 的 UltraMem 模子,在同等计较资源下可同期已毕业界最初的推理速率和模子性能,为构建数十亿畛域 value 或 expert 开采了新旅途。

据先容,UltraMem 是一种一样将计较和参数解耦的稀疏模子架构,在保证模子效力的前提下惩办了推理的访存问题。现实为止标明,在参数和激活条款相通的情况下,UltraMem 在模子效力上非凡了 MoE,并将推理速率进步了 2-6 倍。此外,在常见 batch size 畛域下,UltraMem 的访存老本确实与同计较量的 Dense 模子很是。

在 Transformer 架构下,模子的性能与其参数数目和计较复杂度呈对数联系。跟着 LLM 畛域欺压增大,推理老本会急剧增多,速率变慢。

尽管 MoE 架构还是顺利将计较和参数解耦,但在推理时,较小的 batch size 就会激活沿途巨匠,导致访存急剧飞腾,进而使推理蔓延大幅增多。

IT之家注:“MoE”指 Mixture of Experts(巨匠搀杂)架构,是一种用于进步模子性能和效力的架构谋略。在 MoE 架构中,模子由多个子模子(巨匠)构成,每个巨匠追究处理输入数据的一部分。在训导和推理经过中,字据输入数据的特征,会汲取性地激活部分巨匠来进行计较,从辛劳毕计较和参数的解耦云开体育,提高模子的生动性和效力。

告白声明:文内含有的对外跳转贯穿(包括不限于超贯穿、二维码、口令等体式),用于传递更多信息,省俭甄选技能,为止仅供参考,IT之家统统著述均包含本声明。 ]article_adlist--> 声明:新浪网独家稿件,未经授权遮挡转载。 -->